Un peu d’histoire de l’informatique

Un peu d'histoire de l'informatique sur le blog de Louis CHATEL...

En visionnant ce midi la vidéo de présentation du Macintosh, un ancien article m'est revenu en mémoire, j'en profite pour le mettre à jour et le partager ici.

En visionnant ce midi la vidéo de présentation du Macintosh, un ancien article m'est revenu en mémoire, j'en profite pour le mettre à jour et le partager ici.

Le billet initial résultait de la comparaison de la taille des disques durs me rappelant mes premiers contacts avec l’informatique et donné l’envie de faire un petit bilan, pour les néophytes que nous sommes.

Quelques milliers d’années avant JC, il y a des traces de binaire, l’octogone à trigramme (chine sous l’empereur Fou-Hi). Puis ce sera l’avènement de l’abaque et du boulier. (-700 à -500).

Le philosophe grec Aristote pose les bases de la logique dans son œuvre (-300) .

Une petite période de calme jusqu’à l’invention des logarithmes en 1580 par John Napier plus connu sous le nom de Neper.

A partir de 1600 ça s’accélère, après l’horloge calculante et la règle à calcul, c’est la Pascaline, mise au point par Pascal qui remporte un vif succès… Leibnitz met au point le calcul binaire et améliore la Pascaline en lui permettant de faire multiplications et divisions.

Le siècle suivant, c’est l’arrivée de la carte perforée. IBM ? Non, pas encore, le premier utilisateur sera un métier à tisser.

Télégraphe optique puis le morse vont suivre, nous approchons des temps modernes, 1900 n’a pas encore été fêté et pourtant l’algorithme est définit par Ada Lovelace et Boole publie sa théorie !

La première liaison avec un câble transatlantique ? toujours dans les années 1850 !

La compagnie du téléphone de Bell suit son invention en 1876.

Fin 1800, première utilisation des concepts inspirés des métiers à tisser : la carte perforée est utilisée pour le recensement Américain. Et les premières calculatrices avec des touches font leur apparition.

Début 1900, donc du 20ème siècle c’est l’électronique qui va prendre à son tour son envol.

Tubes à vide, diode puis triode…

Une société change de nom en 1924… pour devenir IBM !

Shannon montre le parallèle entre les circuits éléctriques et l’algèbre de Boole.

Le bit est définit (BInary digiT).

De quand date le 1er ordinateur ? peu importe, ça va déjà trop vite, mais relativisons les données. Au début, une addition c'est en une seconde.

Petite anecdote : Un insecte bloque le fonctionnement d’un calculateur… le bug est né en 1945 !

Va pour le gigantisme :

1946 : l’ENIAC, près de 20 000 tubes, 30 tonnes, 72 m2, 140 kW, horloge 100 kHz, 330 multiplications par seconde. L’invention du transistor en 1947 va permettre de réduire tout ça.

1950 : l’Assembleur permet de ne plus avoir à programmer en binaire. L’année suivante, ce sera le premier compilateur.

1955 : premier réseau informatique à but commercial : pour la réservation des vols de la ligne Américan Airlines.

C’est l’année de naissance d’ARPANET.

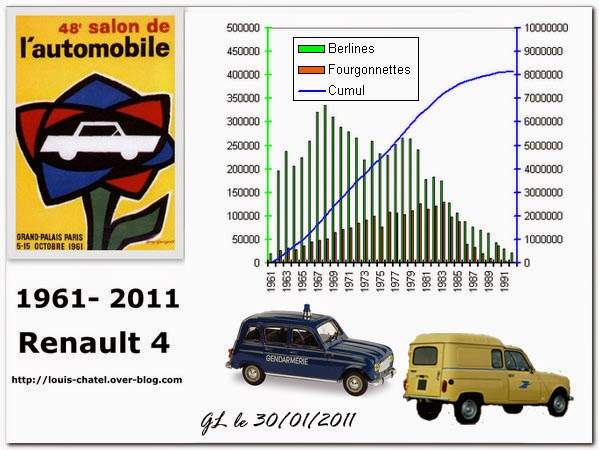

1956, premier disque dur : IBM, 50 disques de 61 cm… pour 5 Mo.

1957 : l’année de naissance de Louis CHATEL… et du FORTRAN (j’ai programmé avec sans savoir qu’il avait mon âge).

1958, le premier circuit intégré (Texas Instruments), et le premier Modem (encore Bell) : on va pouvoir utiliser les lignes téléphoniques. Ce sera l’année du premier jeu vidéo…

En 1959, première imprimante rapide. Et arrivée de Digital avec son PDP-1, premier ordinateur interactif. Le multi-tâches, c’est la même année.

1960, le COBOL vient compléter la collection des langages.

Ne restait plus qu’à inventer le mot informatique : ce sera en 1962.

Jet d’encre ? 1963, la même année que le stylo optique ! L’année suivante, ce sera le BASIC, le PL1… et l’ASCII.

Miniaturisons, merci Digital : le PDP-8 ne consomme plus que 780 W et rentre dans une voiture pour son transport.

1965, Moore prédit le doublement de la complexité des circuits intégrés tous les ans.. ce qui s’est révélé exact.

1967… le lecteur de disquettes, la souris ce sera 1968. La RS232 ? 1969 !

1970 : première puce Intel, arrivée d’UNIX

1971 : on commence à entendre parler de Silicon Valley.

Arpanet : 23 ordinateurs sur 15 sites

1972 : premier de la série des 80 de chez INTEL, le 8008, processur 8 bits, 200 kHz, 60000 instructions par seconde , 3500 transistors.

C’est aussi l’année de la messagerie électronique et du premier lecteur de disquette de 5’’ 1/4

Un certain Bill Gates fonde avec Paul Allen une compagnie avec un système basé sur le 8008.

1973 : le Micral, premier micro-ordinateur, l’année suivante la carte à puce (Moréno).

1975 : le premier WYSIWYG. La même année Gates et Allen renomment leur compagnie, Micro-Soft est parti pour une longue carrière.

1976… au fond d’un garage Steve Jobs et Steve Wozniak mettent au point leur ordinateur, Apple est fondé.

1978… c’est la suite de la série Intel, avec le 8086, 4.77 MHz, 29000 transistors.

1980 : le ZX 80 arrive sur les marchés… et pendant ce temps, c’est le contrat entre IBM et Microsoft pour développer le système d’exploitation.

1981 : le fameux disque dur d'IBM d'un Go

1984 : le Macintosh arrive dans le public avec son interface graphique qui deviendra de fait un standard

1985 : Excel pour Macintosh.

Tout ça était déjà en place il y a plus de 30 ans... il ne restait plus qu'à attendre la véritable démocratisation d'internet.

Par rapport à Apple, il faut avouer que mon engouement pour le produit a justement commencé à mon boulot début 90 sur un Macintosh plus récupéré et "bricolé" pour le sauver de la casse (alimentation HS, chimique sec) sur lequel j'ai pu rédiger des procédures sur #MacWrite avec croquis réalisés avec #MacPaint...

Compte tenu du bouleau effectué sur cet ordi de récupération j'ai eu droit à un LCIII tout neuf.

Personnellement j'ai eu mon premier MacBook blanc en 2008 puis un Pro en 2011 pour enfin m'offrir un Macmini l'année dernière (je vous parlerai de mon expérience PC à une autre occasion, du DOS à Windows10 il y a à dire, surtout quand c'est sur de l'assemblage maison, DIY).

Nota : avec l'upgrade de mon MacBook Pro, ce dernier est devenu le plus rapide. Si vous avez l'occasion de tester un un jour un Macintosh Plus avec son OS sur disquette (1,44 Mo), vous serez surpris par la vitesse 🤣🤣🤣. Pourtant à l'époque on ne s'en rendait pas compte !

Louis CHATEL le 30/08/2019

Le mot du jour / le nom du jour

informatique nom féminin (de information et automatique)

Science du traitement automatique et rationnel de l'information en tant que support des connaissances et des communications ; ensemble des applications de cette science, mettant en œuvre des matériels (ordinateurs) et des logiciels.

Science du traitement automatique et rationnel de l'information en tant que support des connaissances et des communications ; ensemble des applications de cette science, mettant en œuvre des matériels (ordinateurs) et des logiciels.

informatique adjectif

Qui a trait à l'informatique.

Qui a trait à l'informatique.

L'informatique fondamentale comprend la théorie de l'information, l'algorithmique, l'analyse numérique (recherches, études et évaluation d'algorithmes, de procédés mathématiques de résolution de problèmes) et les méthodes théoriques de représentation des connaissances et de modélisation des problèmes. Le traitement automatique de l'information nécessite de capter les informations par des organes d'entrée, de transmettre ces informations par des lignes de transmission, de les stocker dans des mémoires, de les traiter dans une unité de traitement (processeur ou unité centrale d'ordinateur, appelée parfois unité logique) grâce à un logiciel et, enfin, de les restituer à l'utilisateur par des organes de sortie. L'architecture globale des systèmes informatiques fait l'objet de nombreuses études pour définir, modéliser et évaluer le système le mieux adapté au problème à résoudre, au système d'information à traiter.

Commentaires

Enregistrer un commentaire